Les concepts de big data et de données massives représentent l'entrée dans une nouvelle ère technologique. Contrairement à l'intelligence artificielle dont les tenants et aboutissants demeurent plus ou moins nébuleux, les données massives sont un fait avéré. Il est indiscutable qu'une quantité incroyable de données est quotidiennement créée. Le volume des données entreposées double chaque année depuis 2010. Nous mesurerons actuellement les données en termes d'exaoctets (un milliard de gigaoctets) et d'autres dénominations encore plus immenses existent déjà : zettaoctets (1 milliard d'exaoctets) et yottaoctets. Ce qui reste encore sujet à discussion est la façon dont nous allons exploiter ces données pour ajouter de la valeur à nos entreprises et projets.

Premier défi : recrutement de talents

Sans traitement préalable, les données massives n'ont aucune valeur. Il faut les analyser en vue d'espérer en tirer quelque chose d'utile. Afin de créer de la valeur, le domaine du big data est segmenté en différents rôles spécialisés. Chacun de ces rôles requiert un haut niveau de compétence. Il va sans dire qu'un des premiers défis du big data est le recrutement de talents experts en big data :

- Big Data Architect : design de systèmes;

- Big Data Admin : monitoring et maintenance de systèmes;

- Big Data Engineer : ingestion, processing, processing avancé;

- Big Data Analyst : processing, analyse, rapports, visualisation;

- Data Scientist : préparation des données en libre-service (data wrangling), processing avancé, analyse, business insights.

Les applications concrètes du Big Data

- Industrie : assurance qualité et maintenance préventive;

- Distribution : optimisation de l’expérience en magasin et pricing dynamique;

- Banques : prévention de la fraude et du blanchiment d’argent;

- Assurance : tarification personnalisée, prévention de la fraude et prévention des risques;

- Santé : amélioration des diagnostics et gestion des effets indésirables;

- Transports et loisirs : planification et logistique d’événement, économie d’énergie et pricing dynamique;

- Secteur public : prévention de fraudes et abus, personnalisation de la relation citoyen;

- Télécommunication : prévention de fraudes, analyse du comportement client et partage de données de géolocalisation;

- Produits de consommation : analyse de sentiments, gestion des retours de produit, relation avec le consommateur.

Les défis techniques du big data

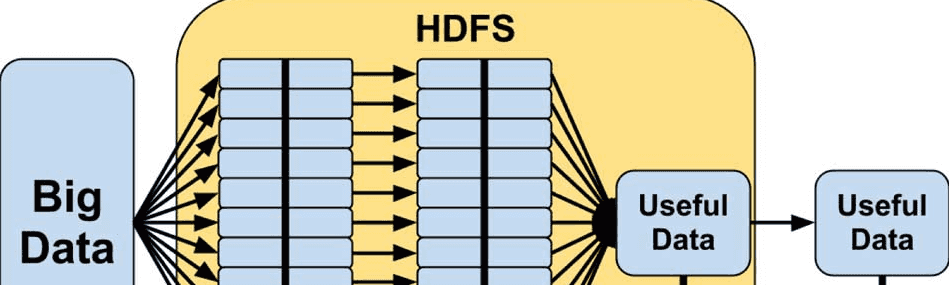

Le premier défi du développeur big data est de gérer l'augmentation des données. Il doit maîtriser les applications spécialisées dans l'ingestion de données. On peut penser aux outils de l'écosystème Hadoop comme Apache Kafka et Apache Flume qui consistent en un canal assurant un système de messagerie ultra-performant. Ou bien Apache Sqoop qui est un outil de transport de données en vrac.

La nature des données entreposées représente un autre défi. La majorité des données massives ne respectent pas un modèle conceptuel connu. Ce sont des documents contenants des données non-structurées ou semi-structurées. D'autre part, le nombre de photos, fichiers audios et vidéos produits augmente à un rythme fou. Mais notre capacité de les analyser de fond en comble n'est pas encore tout à fait achevée.

La création de valeur est la conséquence d'une suite de décisions prisent à la lumière d'analyses des données massives. En effet, l'orchestration de l'ingestion des données de sources diverses, leur analyse et la génération rapide d'insights représente l'ultime défi du big data. C'est-à-dire ajouter de la valeur aux données auparavant non-exploitées. Imaginons par exemple le cas d'un véhicule connecté. On peut espérer sauver des vies humaines dans le cas d'un véhicule automobile qui détecte en temps réel des bris mécaniques, ou un accident, et avertit immédiatement le corps de police local où s'est produit un accident.